정보 자가구축

- 2024-09-08 (modified: 2025-09-29)

정보 자가구축이란 과업 수행에 필요한 정보를 직접 만들어낸다는 뜻이다.1

전통적 관점에서 환경은 수동적으로 그저 존재하는 것이고, 에이전트는 환경에 “이미 있는” 정보를 수용한다. 하지만 확장된 마음에서 소개한 테트리스 사례나 스크래블(단어 게임) 사례 등에서 에이전트는 환경을 수정하여 과업 수행에 필요한 정보를 스스로 만들어낸 후, 혹은 기존 정보를 과업 수행에 적합한 형태로 변형한 후 이를 수용한다. 이를 인식적 행동이라고 한다.

인식적 행동을 통해 세상을 변형하여 필요한 정보를 만들어내는 행위가 정보 자가 구축이다.

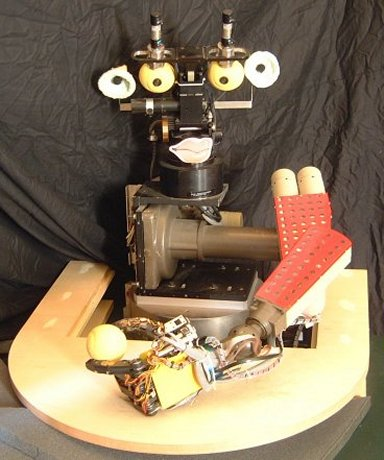

BABYBOT이라고 불리는 학습 로봇의 사례를 보자. (Andy Clark의 Supersizing the mind 1장 6절을 요약)

이 로봇은 팔을 움직여서 세상을 조작하고 이 과정에서 발생하는 시청각 정보를 통해 자신의 몸과 세상에 대해 학습한다. 예를 들어 눈앞에 놓인 물체를 인식하는 문제는 생각보다 쉽지 않다. 정지된 영상으로부터 전경의 물체와 배경 사이의 경계를 분리해야 하기 때문이다. 하지만 팔을 통해 물체를 건드려볼 수 있다면 문제가 더 쉬워질 수 있다. 팔이 물체에 닿는 순간 시각 정보의 패턴이 바뀌기 때문이다(팔만 움직이는 패턴 -> 팔과 팔에 닿은 물체가 함께 움직이는 패턴). 이런 식의 패턴 변화가 있으면 물체의 경계를 더 쉽게 파악할 수 있게 되는 것이다.

이 때 중요한 요소 중 하나는 타이밍이다. 팔의 움직임, 이에 따른 시야의 변화, 또 이와 동시에 발생하는 청각 신호들(모터 소리, 물체에 팔이 닿는 소리 등)이 모두 동기화되어 발생하기 때문에 서로 다른 감각 모드 간의 정보를 통합하여(cross-modal binding) 학습에 활용할 수 있게 된다.

손상이나 성장으로 인한 신체의 변형, 도구 사용으로 인한 신체의 확장, 혹은 짐을 지고 이동하는 상황에서 발생하는 제약 등 여러 이유로 신체의 제어는 적응적일 필요가 있다. Bongard, Zykov, Lipson 2006은 정보 자가 구축을 통해 스스로의 신체 이미지(body image)를 지속해서 학습하는 사족보행 로봇을 만들 수 있었다고 한다. 심지어 이 로봇은 거울에 비친 자신의 신체가 자신임을 식별할 수 있었다고 한다.

마지막으로, Yu, Ballard, Aslin 2005에서는 두 에이전트 사이에서 정보 교류를 위한 수단으로 정보 자가 구축이 활용될 수 있음을 보이고 있다. 돌보미(caregiver) 역할을 하는 사람이 인공신경망에게 단어를 학습시키는 실험이다. 인공신경망은 카메라, 아이트래커, 마이크, 손 움직임 추적 장치 등을 통해 돌보미가 발생시키는 정보를 수용한다. ANN은 언어에 대한 아무런 사전 모델 없이, 전처리되지 않은 여러 정보 흐름들(시각 정보, 청각 정보, 손의 움직임 정보 등)만으로 이미지-단어 매핑을 학습할 수 있었다고 한다. 핵심은 돌보미의 체화된 의도(embodied intention)를 담고 있는 여러 감각 정보의 동기화된(time-locked) 입력이었다. (관련된 다른 자료: The birth of a word)

(언어 모델이 내재되지 않은 인공신경망이라는 세팅은 진화심리학과 잘 안맞는다. 이에 대해서는 나중에 별도의 글로 정리하겠다.)

이 마지막 사례에는 재미있는 함의가 담겨있다. 체화된 에이전트가 몸과 세상을 활용하는 바로 그 전략들이, 다른 체화된 에이전트에게 유용한 정보를 제공할 수 있다는 것이다. 예를 들어 능동적 감지라는 맥락에서, 에이전트의 눈동자 방향은 해당 에이전트의 현재 관심사가 무엇인지를 나타내는 정보이고, 이 정보는 다른 에이전트에 의해 활용될 수 있다(앞의 ANN 사례에서와 같이).